Débuter en Douceur avec de Célèbres Algorithme Utilisés en Intelligence Artificielle

Introduction

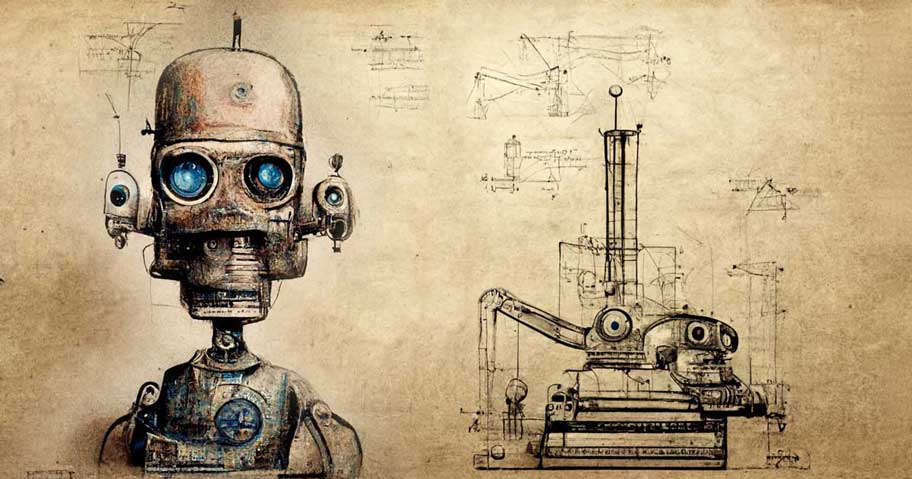

(Excepté les logos, toutes les illustrations de cette page ont été réalisées en collaboration avec Midjourney, l'intelligence artificielle permettant de produire des images à partir de descriptions textuelles).

L'apprentissage automatique, l'apprentissage par renforcement, l'apprentissage supervisé, l'apprentissage non supervisé, l'apprentissage profond, les réseaux de neurones... tous ces concepts peuvent déconcerter lorsque l'on souhaite débuter avec l'intelligence artificielle. Dans les chapitres suivants, vous trouverez divers algorithmes commentés et accompagnés de démonstrations qui ont pour objectif d'aider à la compréhension de ces concepts.

Recherche de Chemin

- L'algorithme de Prim a pour objectif de connecter à moindre coût l'ensemble des noeuds présents dans un graphe.

- L'algorithme de Dijkstra est une version modifiée de l'algorithme de Prim. Il a pour objectif de trouver le plus court chemin entre le noeud de départ et le noeud de destination.

- L'algorithme A* est une version modifiée et souvent moins grourmande de l'algorithme de Dijkstra. Il a pour objectif de trouver potentiellement le plus court chemin entre le noeud de départ et le noeud de destination.

Théorie des Jeux

- L'algorithme Minimax (avec élagage alpha-bêta) est un algorithme décisionnel utilisé dans les jeux à somme nulle, c'est à dire les jeux où la somme des gains et des pertes est nulle, ce que gagne l'un est perdu par l'autre. Son objectif est de maximiser son gain minimum ou de minimiser le gain maximum de l’adversaire.

Apprentissage Automatique

-

L'apprentissage par renforcement est une méthode d'apprentissage qui s'apparente à celle de l'homme. Un agent autonome est plongé au sein d'un environnement avec lequel il intéragit. L'agent développe son propre comportement suite à une serie d'entrainements dans lesquels il reçoit des récompenses positives ou négatives en fonction de ses choix et des règles du système.

- La fonction V (fonction de valeur des états) repose sur un tableau d'estimations dont les index représentent les différents états du système. Chaque état dispose d'une valeur correspondant à une estimation qualitative de cet état.

- Le Q-learning utilise la fonction Q (fonction de valeur des états-actions) qui repose sur un tableau que l'on nomme la Q-table. Les index de cette Q-table représentent les différents états du système. Chaque état dispose d'un tableau d'actions où chacune d'elles possède une valeur correspondant à une estimation qualitative de cette l'action.